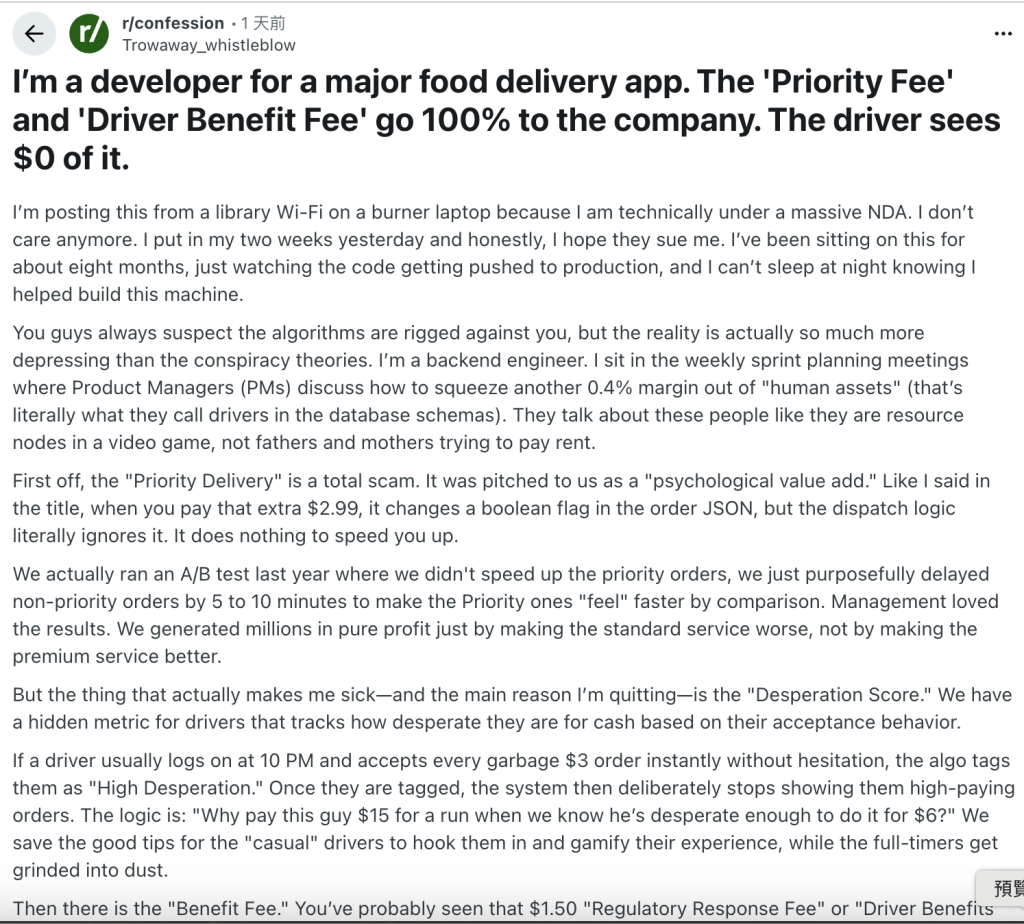

一則 Reddit 上的匿名爆料(原文連結),僅用了幾百字,就摧毀被影射的外送平台經年累月建立的高科技形象,取而代之的是「外送血汗工廠」、「詐欺慣犯」等不名譽的標籤。對任何依賴資料決策與演算法營運的企業而言,這並不是單一產業的八卦,而是一個非常具體的警訊—在 AI 時代,沒有永遠的黑箱。只要企業的演算法邏輯無法通過道德與法律的檢驗,一篇「真實或虛構」的工程師爆料,就足以引爆公關與法律的雙重危機。

台灣《人工智慧基本法》已於 2025 年底經立法院三讀通過,明確揭示「透明與可解釋」、「公平與不歧視」及「問責」等核心原則,並將以風險為基礎建立AI管理法制,強調隱私保護及資料治理的重要性。在即將迎來AI管制的法制環境下,企業若仍抱持「只要沒人發現就好」的心態,所面臨的將不只是公關風險,而是公司治理與高階管理責任的問題。

資料治理在 AI 時代不只是「資安」或「資料品質」的議題,而是企業能不能說清楚、講明白—為什麼要蒐集這些資料?用來做什麼?有沒有越線?出了事以後,能不能拿出一套可回溯、可解釋、可問責的治理機制?

以下以「蒐集、處理、利用」三個資料生命週期,來看像外送平台這類高度依賴騎士、店家與消費者資料的企業,在 AI 時代可以怎麼重新思考資料治理。

一、蒐集階段:合法性、正當性與「你為什麼需要這個資料?」

先撇開 Reddit 爆料真偽不論。就技術上而言,蒐集外送員接單行為、猶豫時間,計算一個「絕望分數」,完全做得到。真正的問題是,企業憑什麼蒐集這些資料,又憑什麼這樣使用?

企業傳統資料思維是—多多益善。只要資訊系統看得到、抓得到,就是資產,先蒐集起來,或許哪天可能用得到。但在現行個資法與新一代 AI 法制(例如後續因應《人工智慧基本法》所修正或新增的立法)之下,這種想法顯然站不住腳。個人資料保護法要求個資蒐集必須有特定目的,且在「目的必要範圍內」為蒐集、處理及利用;《人工智慧基本法》第4條則要求,應妥善保護個人資料隱私,避免資料外洩風險,採取資料最小化原則,並避免演算法產生偏差與歧視等風險。這表示企業在蒐集資料時,必須能回答兩個根本問題:

- 我為何需要蒐集這個資料?

- 例如:蒐集「接單率」用於路徑優化、預測供需,是業務上合理且可解釋的目的。

- 但若是為了推論「這個人經濟壓力大,所以可以丟給他較差的單,他仍會接」,就已經接近「歧視性剝削」,很難通過「公平與不歧視」原則的檢驗。

- 這個資料在企業內部的「分類與定位」是什麼?

- 是履行契約所必須的「交易資料」?

- 還是涉及尊嚴與風險評價的「勞動者評分」?

- 是否實際上被當成「信用評分」、「順從度指標」在用?

要回答這些問題,企業不能只靠臨時解釋,而需要在一開始就建立一套資料分類與用途規則,把每一類資料的性質、可用目的與禁用範圍寫清楚、畫紅線。例如:將資料區分為:基本身分資料、交易資料、行為資料、推論/預測結果等類別;對每一類別標註:是否屬於個人資料、是否敏感、可用目的(履約、風險控管、行銷、模型訓練)與禁止用途。

實務上可行的做法,是要求每一類資料,在內部「資料目錄」中都要有清楚的描述與標籤(例如:性質、來源、可用目的);每一個 AI 模型,都要留下「使用了哪些資料類別」與「對應的特定目的」的文件紀錄。如此一來,當主管機關、工會或社會大眾質疑某種演算法是否合理時,企業不是事後才想理由,而是已經有事前的「資料—目的」對應紀錄可以檢視與辯護。

二、處理階段:打破黑箱,建立「資料血緣」與使用邊界

爆料內容中,最具爭議的一點是「變相吞小費」。將「消費者小費」資料輸入薪酬模型,讓小費變成調降底薪的依據。這是一個非常典型的「目的外利用」,也是非常容易引爆輿論怒火的做法。

過去企業的直覺往往是,「演算法是商業機密,不需要跟任何人解釋內部邏輯。」但在 AI 治理法制下,這種說法將愈來愈站不住腳,尤其是當演算法直接影響勞工權益或消費者權益時,《人工智慧基本法》要求 AI 產出應有適當資訊揭露或標記,以利評估風險並瞭解對相關權益的影響,提升可解釋性與可信度。

在資料治理領域,企業需要做到兩件事:

- 資料血緣(Data Lineage)

- 清楚記錄:資料 A(例如消費者小費)是怎麼被輸入哪些模型,經過哪些處理流程,最後變成了什麼決策(例如調整底薪等級)。

- 這不只是方便工程師除錯,而是未來向主管機關與當事人說明「我們怎麼用資料」的基礎。

- 使用邊界(Usage Boundary)

- 同一筆資料,可以在什麼脈絡下被視為「合法與合理」的使用?

- 又在哪些情境下,使用同一筆資料就變成「目的外利用」甚至「侵害勞工權益」?

如果企業能在資料分類與內部規則中,對例如「小費」這類資料做出明確界定,像是:性質上屬於顧客自願支付,指向勞工報酬;不得用於調降底薪或扣抵基本報酬之用途;不得進入影響薪資結構與勞動條件的運算流程等。只要有人企圖把「小費」變成薪酬模型中的一個變數,資料治理與內控機制就應該自動啟動警示,因為這不是單純「技術調整」,而是觸及資料治理與勞動權益的紅線。

換句話說,透過資料血緣與清楚的分類/用途規則,企業可以不需要是事後被迫解釋「我們沒有偷小費」,而是事前就能說,「依照我們的資料治理架構,這種用途在技術與流程上就被禁止、被隔離。」這樣的結構設計,對董事會與高階主管來說,也是未來面對主管機關與法院時,主張「已盡合理注意義務」的重要防線。

三、利用階段:從「能做什麼」轉向「該不該做」

爆料中提及的「優先費造假」與「刻意延遲 A/B 測試」、「差別對待付費/未付費使用者」,從技術角度看幾乎完全沒有門檻;也正因為技術上可行,一般使用者才會相信「平台也有可能這樣做」。

對企業而言,真正的挑戰是:AI 讓你「很多事都做得到」,但公司治理必須回答:「哪些事,即便做得到,也不能做?」

《人工智慧基本法》第 5 條要求政府避免 AI 應用有侵害人民生命、身體、自由或財產,或出現偏差、歧視、廣告不實、資訊誤導或造假等違法情事。這些規範雖然是對政府的要求,但未來必然會透過個資法、消費者保護法、公平交易法等具體法律,折射到企業的具體法律責任。

在資料治理與 AI 治理的交界處,企業需要引進的不只是技術審查,而是「決策倫理」與「法律風險評估」:

- 辨識「高風險演算法」

- 所有涉及差別待遇、動態定價或行為操縱的演算法,都應被視為高風險情境。

- 這些演算法不應僅由產品或行銷部門決定,而需納入法遵、風險管理與高階管理層的共同審查。

- 建立「演算法倫理與法遵審查程序」

- 除了看 KPI(轉換率、利潤),還要評估:

- 是否構成資訊不對稱下的操縱?

- 是否可能形成實質歧視或不當差別待遇?

- 是否可能被認定為廣告不實或誤導?

- 除了看 KPI(轉換率、利潤),還要評估:

- 將這些規則內嵌到資料與系統設計中

- 在資料層面:對用於這類演算法的資料加註「高風險用途」標示,限制可觸碰的資料範圍。

- 在系統層面:要求這類實驗或 A/B 測試,必須有清楚的紀錄與審查軌跡,而非任由個別團隊自由發揮。

如此一來,當使用者的「體感」認為「付了優先費也沒有比較快」、「不付錢就被冷落」時,企業可以拿出具體機制與紀錄說明,系統的實際運作邏輯是什麼?哪些做法明確被禁止?出現爭議時有哪些補救與檢討程序?這比起單純發一則「我們重視用戶體驗、絕不會如此操作」的空泛聲明,要具體且有說服力得多。

結語:AI 治理法制時代,企業不能再用「機密」當擋箭牌

AI 治理法制化帶來的最大改變之一,是企業再也不能只靠「黑箱」、「商業機密」來回應社會對資料與演算法的質疑。當《人工智慧基本法》要求透明、可解釋、公平與問責,未來也可能透過風險分級、影響評估等具體立法,要求企業說清楚 AI 如何被設計與使用。此時,資料治理就不再只是後勤支援,而是公司治理的前線。清楚的資料分類與用途規則、資料血緣、演算法審查機制,並不會讓企業完全避免所有爭議,但它們可以做到幾件關鍵的事:

- 讓企業在蒐集資料時,就被迫回答「為什麼需要」與「能做到哪裡就好」。

- 讓 AI 在處理資料時,有清楚的使用邊界與技術閘門,而不是任意串接。

- 讓演算法在利用資料做出差別待遇或高風險決策時,必須先通過倫理與法遵的檢驗。

當匿名爆料與輿論壓力接踵而來時,有沒有做這些事,差別就在於,沒做到的企業只能發一則沒幾個人相信的聲明稿,祈禱風暴盡快過去;有做到的企業則可以拿出完整的資料治理架構、資料流動地圖與決策紀錄,清楚說明哪些技術雖然可行,但我們沒有做,也制度上不允許我們去做。

在不確定成為常態的時代,資料治理已經不只是「守法」問題,而是企業向員工、使用者與社會交代「我們是怎麼做決策」的核心責任。而在 AI勢將普及應用的時代,這份責任愈來愈有賴一套清晰的資料結構與可被驗證的治理機制來支撐。